🚀 ¿Quieres que tu negocio aparezca aquí?

Da a conocer tus servicios ante una comunidad de profesionales del mundo digital, startups y desarrolladores.

Hola 👋

Esta semana charlamos con Ángel, cofundador de Rover (by Endor), una herramienta open source que permite lanzar agentes de código de forma autónoma y segura en tu propio entorno. Rover crea una sandbox con Docker y Git, analiza el contexto del proyecto, planifica, implementa y deja un resumen claro de los cambios realizados. Se acabó hacer de “niñera de IAs”: lanzas la tarea y revisas los resultados cuando quieras, incluso desde VS Code.

También profundizamos en el equilibrio entre autonomía y control, y en cómo un MCP Gateway puede convertirse en el punto único de acceso a tu documentación, repositorios y APIs. ¿El resultado? Menos tiempo perdido buscando información, onboarding más rápido y un código más consistente y de mayor calidad.

🧠 G33K TEAM de la Semana

¡Ya está disponible el episodio 20 de G33K Team! 🎙️

Esta semana, Oriol Rius, Tete y Aitor Roma reciben a dos invitados de lujo: Ángel y Rafa, los cerebros detrás de Endor y su revolucionario proyecto Rover. Prepárate para una inmersión profunda en el futuro del desarrollo de software con agentes de inteligencia artificial.

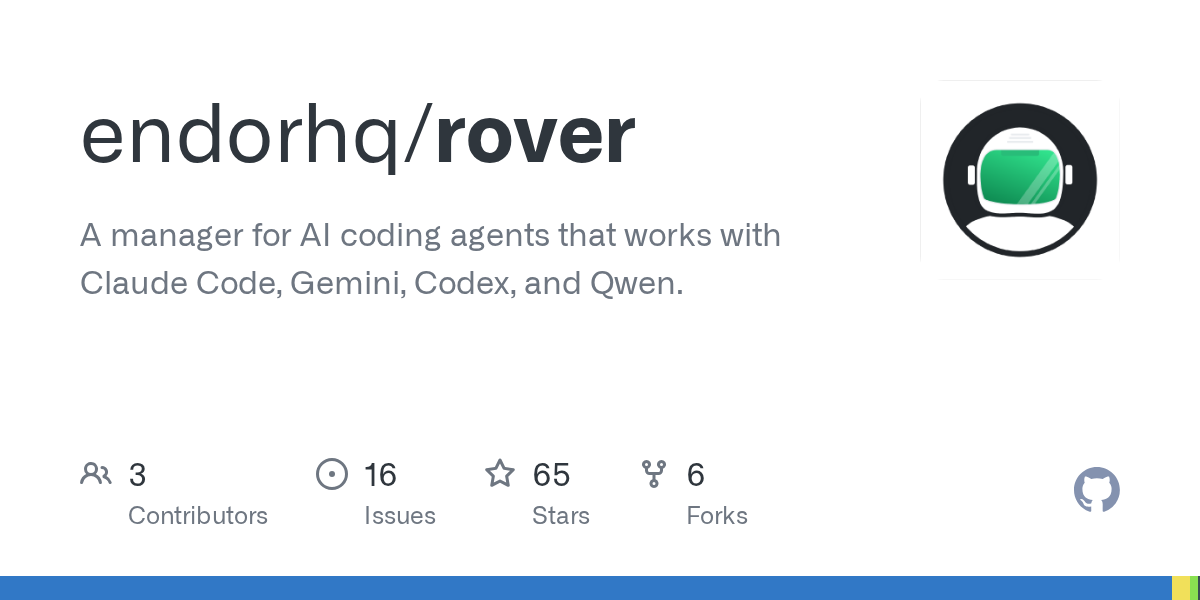

🤖 Orquestando Agentes de IA con Rover

¿Imaginas delegar tareas de codificación a un agente de IA que trabaja de forma autónoma y segura en tu propia máquina? Ángel y Rafa nos presentan Rover, un gestor de agentes de IA de código abierto que está cambiando las reglas del juego.

- ¿Qué es Rover?: Es una herramienta que crea un entorno de desarrollo completo y aislado (una sandbox) para que un agente de IA pueda ejecutar tareas de programación de principio a fin. Utiliza tecnologías como Docker y Git para garantizar que el agente no interfiera con tu trabajo ni ponga en riesgo tu sistema.

- El fin del "canguro de IAs": La filosofía de Rover es clara: que el desarrollador pueda centrarse en su trabajo mientras el agente se encarga de una tarea en segundo plano. Se acabaron las horas mirando una pantalla de chat esperando a que la IA termine. Con Rover, lanzas la tarea y revisas los resultados cuando estés listo.

- Un flujo de trabajo inteligente: Rover no se limita a ejecutar comandos. Sigue un workflow estructurado que incluye:

- Análisis de contexto: Entiende el proyecto actual.

- Planificación: Desglosa la tarea en pasos lógicos.

- Implementación: Escribe y modifica el código.

- Revisión y Resumen: Valida los cambios y genera un informe claro de lo que ha hecho.

- Colaboración y control: Durante la demo, vimos cómo Rover permite inspeccionar el trabajo del agente, ver los cambios realizados e incluso abrir un workspace aislado en VS Code para hacer ajustes manuales. Además, se abre la puerta a la orquestación de múltiples agentes (uno que programa, otro que revisa, otro que testea...), llevando la colaboración a un nuevo nivel.

🤔 El debate: autonomía vs. control

La conversación nos llevó a reflexionar sobre los grandes desafíos del uso de agentes de IA:

- ¿Cómo mantenemos el control sin sacrificar la autonomía del agente?

- ¿Cómo gestionamos las "colisiones" cuando varios agentes (o un agente y un humano) trabajan sobre el mismo código?

- La importancia de definir un buen contexto para que la IA no se pierda y queme tokens innecesariamente.

Una charla imprescindible para entender cómo estamos pasando de simplemente "usar" la IA a "orquestarla" para potenciar nuestra productividad como nunca antes.

🔗 Enlaces mencionados:

- Rover en GitHub: https://github.com/endorhq/rover

🎙️ Entrevista Exclusiva: Ángel de Rover (by Endor) — cómo lanzar agentes de código que trabajan por ti

🚀 Introducción

Hoy tenemos el placer de conversar con Ángel, uno de los creadores de Rover (by Endor), un gestor de agentes de codificación con inteligencia artificial que permite crear y completar tareas en segundo plano utilizando agentes como Claude Code, Qwen, Gemini o Codex.

Lo más interesante de Rover es que trabaja con los agentes que ya tienes instalados en tu propio sistema —sin necesidad de nuevas suscripciones ni tokens de API— y ejecuta las tareas en un entorno totalmente aislado.

En esta entrevista, Ángel nos cuenta cómo surgió la idea, qué problemas resuelve y cuáles son los siguientes pasos del proyecto.

💡 Sobre Rover (by Endor)

Rover es un gestor de coding agents con inteligencia artificial que permite automatizar tareas de desarrollo en segundo plano. Cada agente trabaja de forma autónoma sobre una copia del código en un contenedor aislado, lo que multiplica la productividad sin interrumpir el flujo de trabajo del desarrollador.

📂 Categoría: Desarrollo y TI

🧑💻 Entrevista con Ángel CTO de Endor

¿Quién es Ángel? Cuéntanos un poco sobre ti, tu formación y cómo llegaste a ser desarrollador.

Empecé desde muy pequeño a trastear con el ordenador MS-DOS de mi padre. Primero jugando al Pang y luego aprendiendo poco a poco a entenderme con la consola de comandos.

Aunque siempre me interesó mucho, no empecé a programar hasta llegar a la Facultad de Ingeniería de Sevilla para estudiar Telecomunicaciones. Desde entonces, el desarrollo me fascinó: desde ensamblador y C hasta desarrollo web.

Mi primer trabajo fue desarrollando dashboards para una empresa de ciberseguridad. Un año después entré en Bitnami, donde trabajé en frontend, backend, automatización e infraestructura.

Tras las adquisiciones por parte de VMware y Broadcom, decidí tomarme un descanso. Poco después retomé el contacto con Daniel (fundador de Bitnami y del equipo de WasmLabs en VMware), y decidimos lanzar Endor.

¿Quiénes o qué han sido tus mayores influencias como desarrollador?

Sería difícil enumerarlas todas, porque he tenido la suerte de trabajar con gente extraordinaria.

Diría que la comunidad de UX de España marcó mucho mi carrera, ya que fueron mis primeras conferencias. De ellos aprendí a pensar siempre en las personas que usan los proyectos.

No tengo grandes nombres que mencionar, pero sí muchos compañeros y compañeras con los que podía debatir durante horas sobre distintos temas. Y por suerte, aún tengo a muchos cerca.

¿Cuál es tu opinión más controvertida sobre la programación?

No es sobre programación en sí, pero creo que todos los roles de una empresa deberían dedicar algo de tiempo a trabajar en soporte.

Mantenerte cerca de tus usuarios te da una perspectiva que ningún informe te puede ofrecer.

¿Cuál es tu herramienta de software favorita y por qué?

Sin duda, la terminal.

Muchas veces prefiero una aplicación de terminal en lugar de una de escritorio porque suelen ir más al grano.

Aunque soy una persona muy centrada en las interfaces, cuando se trata de productividad prefiero evitar distracciones.

¿Por qué comenzaste Rover (by Endor)?

Rover nació como una herramienta interna.

En Endor nos dimos cuenta de que, después de una semana utilizando agentes de código, tendíamos a usarlos cada vez menos.

Leer la salida de un modelo de IA te desconecta del proyecto y del código.

Así nació Rover como un proyecto para lanzar agentes en segundo plano. La idea cuajó y empezamos a usarlo cada vez más. De hecho, parte de Rover está implementada por el propio Rover.

Finalmente decidimos liberarlo como proyecto de código abierto.

¿Cómo funciona Rover (by Endor) y qué problemas resuelve?

Rover te permite lanzar agentes de IA en segundo plano que operan de manera autónoma.

Cada tarea tiene asociada una rama en Git y una copia del estado actual del repositorio.

Se lanza un contenedor, se instala el agente elegido y este completa la tarea.

Puedes ejecutar varias tareas en paralelo sin colisiones ni distracciones.

Los agentes guardan trazas de lo que hacen y tú decides cuándo revisar, hacer merge o pedir nuevas iteraciones.

Todo ocurre en tu sistema: tienes control total sobre los repositorios, los agentes y los cambios que aplican.

¿Por qué elegiste el lenguaje de programación que utilizaste para Rover (by Endor)?

Rover está desarrollado en JavaScript (TypeScript).

Es sencillo crear interfaces de línea de comandos (CLI) con JavaScript, y además el equipo ya tenía experiencia.

También, al ser un proyecto de código abierto, queríamos que cualquiera pudiera contribuir.

Muchos proyectos de IA están escritos en JavaScript, por lo que es un lenguaje familiar para la comunidad.

Otras opciones que consideramos fueron Rust y Go.

¿De dónde viene el nombre de Rover (by Endor)?

El nombre viene de la temática espacial que tenemos en Endor.

Rover nació como un proyecto de exploración de agentes de IA, así que el nombre le venía como anillo al dedo.

¿Cuál ha sido el problema más desafiante que habéis resuelto en Rover (by Endor) hasta ahora?

Sin duda, conseguir que agentes de código tan distintos como Gemini, Claude y Codex puedan completar tareas de forma consistente.

Gemini nos ha dado más de un quebradero de cabeza, ya que a veces tiene problemas para utilizar sus propias herramientas.

¿Cuáles son vuestras metas para el futuro de Rover (by Endor)?

Queremos que Rover se convierta en una herramienta más versátil y que permita un uso eficiente de los agentes de código para el desarrollo.

Con Rover buscamos que cualquier persona pueda usar el agente que prefiera y que, entre tantas novedades, tenga una herramienta estable sobre la que construir sus proyectos futuros.

🙌 Agradecimientos

Muchas gracias, Ángel, por compartir la historia detrás de Rover (by Endor) y dedicar tu tiempo a esta entrevista.

Queremos extender también nuestro agradecimiento a todo el equipo de Endor por desarrollar un proyecto tan interesante, y en especial a Rafa, por facilitar el contacto y hacer posible esta conversación.

¡Un placer teneros en NoCodeOpenSource! 🚀

ℍ𝕠𝕣𝕚𝕫𝕠𝕟𝕥𝕖 𝔸𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝

Te presentamos "Horizonte Artificial", la nueva y flamante sección de nuestra newsletter dedicada exclusivamente a la Inteligencia Artificial. Pero no esperes el contenido convencional que inunda TikTok o YouTube. Aquí, nos sumergiremos en el fascinante mundo del OpenSource, explorando proyectos libres que puedes desplegar en tu propio servidor. Y para guiarnos en esta travesía, contamos con la experticia de Jesús Pacheco, mejor conocido en nuestra comunidad HiveAgile como "Pachecodes". Prepárate para una perspectiva fresca y auténtica sobre la IA. ¡Bienvenidos al horizonte!

🌟 TopGit - Resumen Semanal (2025-10-10)

📚 Repositorios Destacados de la Semana

Los siguientes repositorios han sido seleccionados por su relevancia, calidad y métricas de GitHub:

🔧 🚀 JSCamp InfoJobs

Bienvenidos al bootcamp intensivo de JavaScript y desarrollo web full-stack diseñado para llevarte desde los fundamentos hasta las tecnologías más avanzadas del ecosistema JavaScript. En este curso aprenderás HTML, CSS, JavaScript, TypeScript, Node.js, SQL, CI/CD y Docker mientras construyes un proyecto completo desde cero. Además, tendrás acceso a contenido exclusivo y soporte de la comunidad.

📊 Estadísticas de GitHub:

- ⭐ 2,554 estrellas

- 🔄 259 forks

- 👀 51 observadores

- 📝 0 issues abiertos

- 🔤 Principal lenguaje: CSS

🔧 🤖 Herramienta de Automatización Social

GrowChief es una herramienta de automatización de redes sociales de código abierto que permite a los usuarios crear flujos de trabajo para interactuar con diversas cuentas, como enviar solicitudes de conexión y mensajes de seguimiento. Es perfecta para integraciones con n8n, Make o Zapier. Además, cuida la concurrencia, utiliza movimientos de mouse naturales y permite proxies para una mayor seguridad.

📊 Estadísticas de GitHub:

- ⭐ 3,138 estrellas

- 🔄 207 forks

- 👀 3 observadores

- 📝 2 issues abiertos

- 🔤 Principal lenguaje: TypeScript

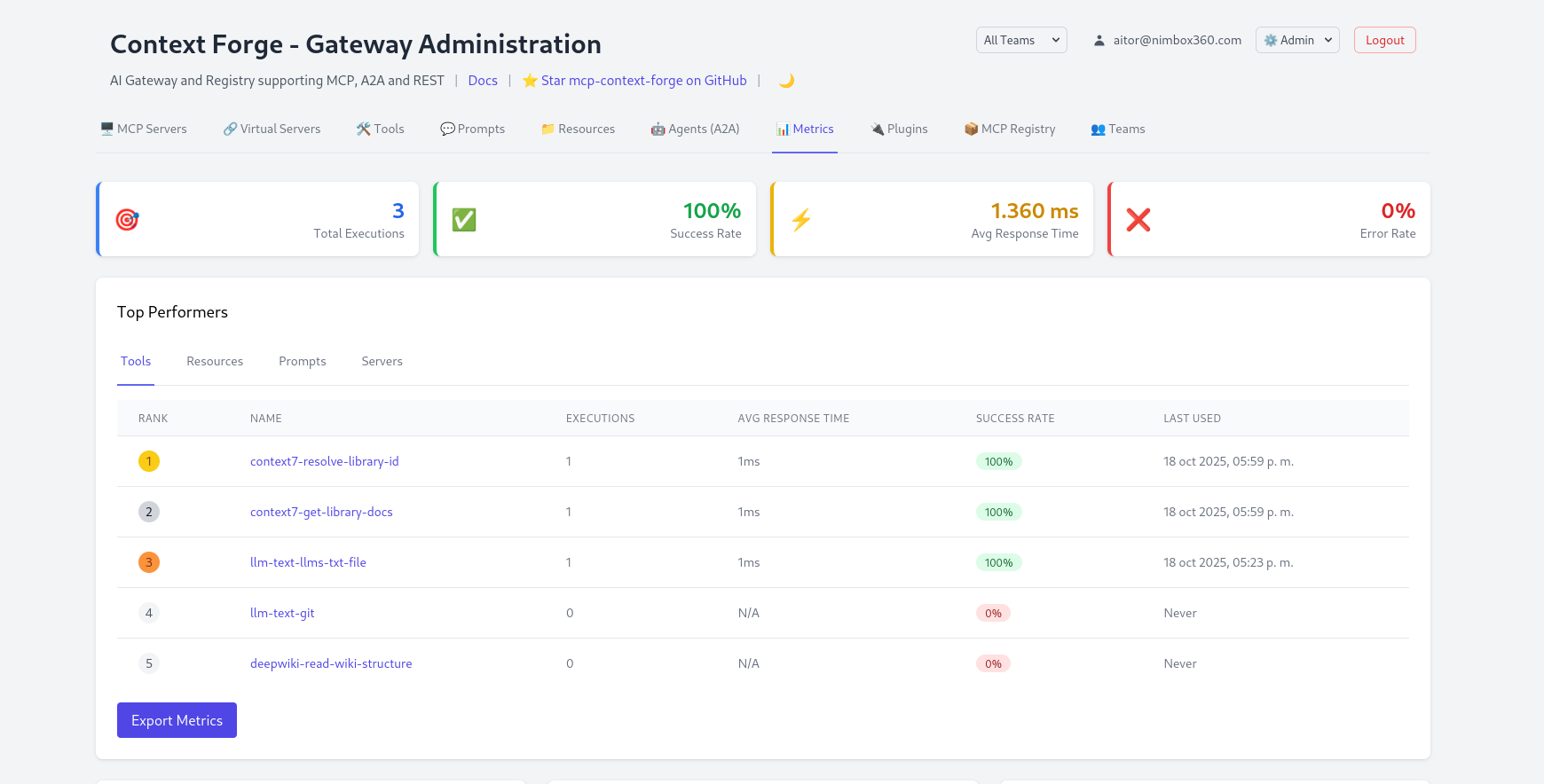

🔧 🧠 MCP Context Forge

MCP Context Forge es un gateway, registro y proxy que se coloca frente a cualquier servidor del Protocolo de Contexto del Modelo (MCP), servidores A2A o REST, exponiendo un punto final unificado para todos tus clientes de IA. Su propósito es proporcionar una manera eficiente de gestionar servicios y herramientas que implementen MCP, mejorando la accesibilidad y seguridad.

📊 Estadísticas de GitHub:

- ⭐ 2,685 estrellas

- 🔄 341 forks

- 👀 30 observadores

- 📝 230 issues abiertos

- 🔤 Principal lenguaje: Python

🔧 🧠 Chatterbox TTS Multilingüe

Chatterbox Multilingual es un modelo de TTS de código abierto de Resemble AI que soporta 23 idiomas de forma nativa. Con licencia MIT, ha sido comparado con sistemas de pago y es preferido en evaluaciones. Ideal para memes, videos, juegos y agentes AI, Chatterbox incorpora control de exageración de emociones y clonación de voz multilingüe.

📊 Estadísticas de GitHub:

- ⭐ 14,010 estrellas

- 🔄 1,836 forks

- 👀 93 observadores

- 📝 202 issues abiertos

- 🔤 Principal lenguaje: Python

🔧 🧠 Crea Tu Propio Agente de Programación

¡Bienvenido! 👋 Este taller te guiará para construir tu propio asistente de programación impulsado por IA. Comenzarás con un chatbot básico y le agregarás herramientas poderosas como lectura de archivos, ejecución de comandos de shell y búsqueda de código. No necesitas ser un experto en IA. ¡Simplemente sigue los pasos y construye!

📊 Estadísticas de GitHub:

- ⭐ 3,781 estrellas

- 🔄 426 forks

- 👀 22 observadores

- 📝 4 issues abiertos

- 🔤 Principal lenguaje: Go

🔧 💻 Midday - Gestión para Freelancers

Midday es una herramienta integral diseñada para ayudar a freelancers, contratistas y emprendedores a gestionar sus operaciones comerciales de manera más eficiente. Integra diferentes funciones como seguimiento de tiempos, facturación y almacenamiento de archivos en un solo sistema cohesivo.

📊 Estadísticas de GitHub:

- ⭐ 12,650 estrellas

- 🔄 1,172 forks

- 👀 72 observadores

- 📝 17 issues abiertos

- 🔤 Principal lenguaje: TypeScript

🔧 💻 Uso de Computadora Abierta

Uso de Computadora Abierta es una plataforma de código abierto que brinda control real a agentes de IA a través de la automatización del navegador, acceso a terminal y interacción con el escritorio. Diseñada para desarrolladores que desean crear flujos de trabajo de IA verdaderamente autónomos.

- ✅ Navegación web como un humano

- ✅ Ejecución de comandos en terminal

- ✅ Control de aplicaciones de escritorio con automatización UI

- ✅ Orquestación de múltiples agentes

- ✅ Código 100% abierto y autohospedable

Esta herramienta permite tareas complejas que requieren interacción humana, como busquedas web, gestión de archivos y ejecución de comandos, facilitando procesos automatizados en diferentes ámbitos.

📊 Estadísticas de GitHub:

- ⭐ 157 estrellas

- 🔄 14 forks

- 👀 1 observadores

- 📝 1 issues abiertos

- 🔤 Principal lenguaje: TypeScript

🔧 💻 Herramienta de Respaldo MongoDB

mdbdump es una herramienta simple de respaldo para MongoDB escrita en Python, que permite realizar copias de seguridad de múltiples clústeres de MongoDB. Exporta todas las bases de datos, colecciones y esquemas a archivos JSON con rotación automática. Ideal para mantener la integridad de los datos y la continuidad del negocio.

📊 Estadísticas de GitHub:

- ⭐ 2 estrellas

- 🔄 0 forks

- 👀 0 observadores

- 📝 0 issues abiertos

- 🔤 Principal lenguaje: Python

📊 Análisis de Distribución por Categorías

La siguiente gráfica muestra la distribución de proyectos por categoría en TopGit:

📈 Estadísticas Semanales

🏆 Top 3 Categorías

📊 Distribución Detallada

⚡ Productivity ███████ 38% (3 repos)

🤖 IA & Machine Learning ███████ 38% (3 repos)

🔧 Dev ██ 12% (1 repos)

🌐 Web Development ██ 12% (1 repos)

🚀 Tendencias Destacadas

📈 Métricas Clave

- Repositorios Totales: 8

- Promedio Diario: 1.1 repos/día

- Categorías Activas: 4

🎯 Categorías Dominantes

- Productivity

- 3 repositorios

- 37.5% del total

- IA & Machine Learning

- 3 repositorios

- 37.5% del total

- Dev

- 1 repositorios

- 12.5% del total

💡 Análisis de Tendencias

Esta semana se observan varias tendencias interesantes en GitHub. En la lista de proyectos destacados, se puede notar un fuerte enfoque en la Inteligencia Artificial (IA), el aprendizaje automático y la automatización, reflejando el continuo avance e interés en estas áreas dentro del campo de la tecnología.

A destacar, el proyecto "MCP Context Forge" de IBM, un protocolo que mejora la gestión de servicios IA; "Chatterbox TTS Multilingüe", un sistema avanzado de Texto a Voz con capacidades multilingües y capacidad de clonación de voz; y "Crea Tu Propio Agente de Programación", un taller paso a paso para construir un asistente de programación basado en IA. Estos repositorios no solo muestran la creciente relevancia de la IA, sino también un notable interés en las herramientas educativas y de autoaprendizaje.

Asimismo, la automatización es otra tendencia evidente. El proyecto "Herramienta de Automatización Social" indica el creciente uso de flujos de trabajo automatizados para las redes sociales, mientras que "Uso de Computadora Abierta" va un paso más allá, buscando crear agentes de IA capaces de recrear el uso humano de una computadora, incluyendo tareas complejas que tradicionalmente necesitaban interacción humana.

Por otro lado, la simplificación y eficacia de los procesos de trabajo también son un foco constante. "Midday - Gestión para Freelancers" busca proporcionar una solución de gestión integral para freelancers, optimizando varias funciones en un único sistema que mejora la eficiencia.

Finalmente, la seguridad y protección de datos sigue siendo una preocupación clave. "Herramienta de Respaldo MongoDB" es un proyecto que permite a los usuarios realizar copias de seguridad de sus clústeres de MongoDB, asegurando la integridad de los datos y la continuidad del negocio.

En general, las tendencias sugieren un continuo interés en la IA, el aprendizaje automático, la automatización y la eficacia de los sistemas de trabajo. También resalta la relevancia creciente de la educación

- 🐥 Únete a nuestra vibrante comunidad en Twitter y mantente en la vanguardia: descubre herramientas innovadoras, participa en nuestro emocionante #BuildInPublic y mucho más.

- 💌 ¿Tienes algo que compartir? No dudes en contactarnos. Tu voz es importante para nosotros y nos comprometemos a responder a la mayor brevedad posible.¡házmelo saber!

Era martes por la tarde cuando Laura, nuestra Tech Lead, entró a la sala de reuniones con esa mirada que todos conocíamos: algo estaba mal, muy mal.

"Acabo de revisar los números", dijo mientras proyectaba una hoja de cálculo. "Nuestros desarrolladores pasan 18 horas a la semana buscando documentación, ejemplos de código y preguntando en Slack cómo usar nuestras propias APIs internas."

El silencio fue incómodo. Todos lo sabíamos, pero verlo cuantificado dolía.

Teníamos 47 microservicios, 12 librerías internas, APIs de terceros (Stripe, AWS, Twilio), y cada semana alguien preguntaba: "¿Cómo se autentica contra el servicio de usuarios?" o "¿Qué parámetros acepta el endpoint de facturación?"

La documentación existía, sí. Dispersa en Confluence, README desactualizados, Postman collections que nadie mantenía, y ese Notion que alguien creó con buenas intenciones hace 8 meses.

El Descubrimiento

Todo cambió cuando Marcos, uno de nuestros senior developers, llegó un lunes con los ojos brillantes.

"Encontré algo", dijo. "Se llama Model Context Protocol. Es un estándar que permite que los LLMs accedan a herramientas, recursos y contexto de forma estructurada."

Nos mostró cómo editores como Cursor y Windsurf podían conectarse a servidores MCP y acceder a información en tiempo real: bases de datos, APIs, documentación, todo.

"Imaginen", continuó, "que cada desarrollador tuviera un asistente AI que conoce nuestro código, nuestras APIs, nuestros estándares. No que adivina o alucina, sino que consulta la fuente de verdad."

La idea era brillante, pero había un problema: cada desarrollador tendría que configurar decenas de servidores MCP individuales. Inviable.

La Solución: MCP Gateway

Investigando, encontramos MCP Context Forge de IBM: un gateway centralizado que actúa como punto único de acceso a múltiples fuentes de información.

La arquitectura era elegante:

Desarrolladores (Cursor, Windsurf)

↓

MCP Gateway (único punto)

↓

┌──────┴──────┬──────────┬──────────┐

↓ ↓ ↓ ↓

Context7 LLM Text APIs Bases de

(docs) (scraping) Internas Datos

Equipos No Técnicos (OpenWebUI)

↓

MCP Gateway (mismo punto)

↓

Herramientas específicas por equipo

Lo que Nos Convenció

- Centralización: Un solo servidor para todo el equipo

- Autenticación: OAuth, JWT, control de acceso por equipos

- Federación: Podíamos conectar múltiples fuentes (Context7 para docs, GitHub para código, nuestras APIs)

- Observabilidad: Logs, métricas, trazabilidad de qué consulta cada desarrollador

- Multi-tenant: Equipos separados con acceso a diferentes recursos

La Implementación: Semana 1

Día 1-2: Infraestructura Base

Decidimos usar Docker Compose para desarrollo y Kubernetes para producción. La configuración inicial fue sorprendentemente simple.

Configuramos:

- PostgreSQL para persistencia (usuarios, equipos, configuraciones)

- MCP Gateway con autenticación JWT

- Admin UI habilitada para gestión visual

Día 3-4: Conectando Fuentes Externas

Aquí fue donde la magia empezó. Registramos gateways MCP públicos que ya existían:

Context7 - Documentación actualizada de miles de librerías:

- Express.js, FastAPI, PostgreSQL, Redis, AWS SDK

- React 18, Next.js 14, TailwindCSS, shadcn/ui

- Kubernetes, Docker, Terraform, GitHub Actions

LLM Text - Análisis de texto y scraping web:

- Extracción de contenido de sitios

- Análisis de repositorios Git

- Procesamiento de documentación

El gateway importó automáticamente todas las herramientas de estos servidores. Luego creamos servidores virtuales para cada equipo, seleccionando qué herramientas tenía disponible cada uno.

Día 5: Organizando por Equipos

Creamos servidores virtuales para cada equipo, agrupando las herramientas relevantes:

Servidor Backend: Context7 (docs de librerías), LLM Text (análisis de código)

Servidor Frontend: Context7 (docs de frameworks), herramientas de UI

Servidor DevOps: Context7 (docs de infraestructura), herramientas de monitoring

Cada equipo solo veía las herramientas que necesitaba. Sin configuración local, sin complejidad.

El Primer Día en Producción

Configuramos a 5 desarrolladores como beta testers. Les dimos acceso al gateway y una guía de 10 minutos para configurar Cursor y Windsurf.

A las 2 horas, recibimos el primer mensaje en Slack:

Carlos (Frontend): "Chicos, acabo de preguntarle al AI en Cursor cómo implementar autenticación con nuestro servicio de auth. Me dio el código exacto, con nuestros endpoints, nuestras variables de entorno. No tuve que buscar nada. WTF."

A las 4 horas:

Ana (Backend): "Le pedí en Windsurf que me generara un endpoint siguiendo nuestros estándares de la empresa (validación Zod, manejo de errores, logging). Lo hizo perfecto. Conoce nuestro código base."

A las 6 horas:

Marcos: "Acabo de refactorizar un servicio legacy preguntándole al AI. Tiene acceso a la documentación de la API vieja Y la nueva. Me generó el migration path completo."

Tres Meses Después: Los Números

Laura volvió a la sala de reuniones, esta vez sonriendo.

Antes del MCP Gateway:

- ⏱️ 18 horas/semana buscando documentación

- 📚 47 preguntas/semana en Slack sobre "cómo usar X"

- 🐛 12% de bugs por uso incorrecto de APIs internas

- 😤 Frustración generalizada con onboarding (3 semanas para nuevos devs)

Después del MCP Gateway:

- ⏱️ 3 horas/semana (83% reducción)

- 📚 8 preguntas/semana (83% reducción)

- 🐛 3% de bugs (75% reducción)

- 😊 Onboarding en 4 días

ROI Calculado:

- 15 horas/dev/semana × 23 devs × $75/hora = $25,875/semana ahorrados

- $1.3M/año en productividad recuperada

Pero los números no cuentan toda la historia.

El Impacto Real

Onboarding Transformado

Antes: "Aquí está el Confluence, lee durante 2 semanas y pregunta lo que no entiendas."

Ahora: "Aquí está tu acceso al MCP Gateway. Pregúntale lo que necesites, tiene todo nuestro contexto."

Los nuevos desarrolladores eran productivos en días, no semanas.

Menos Context Switching

Los desarrolladores dejaron de saltar entre:

- Navegador (docs)

- Slack (preguntar)

- Postman (probar APIs)

- Confluence (buscar ejemplos)

Todo estaba en su IDE, en su flujo natural de trabajo.

Mejor Código

El AI no solo conocía las APIs, conocía nuestros estándares:

- Patrones de arquitectura

- Convenciones de naming

- Estructura de tests

- Manejo de errores

El código generado era consistente con nuestra base existente.

Potenciando Otros Equipos: El Caso de Marketing

Cuando el equipo de desarrollo vio los resultados, surgió una pregunta: ¿Por qué solo desarrollo?

Laura y Marcos se reunieron con Patricia, la directora de Marketing, quien tenía sus propios dolores:

Patricia: "Mi equipo pasa horas creando contenido, programando posts en redes sociales, analizando métricas de Meta Ads. Cada herramienta es un silo diferente. ¿El AI podría ayudarnos?"

La respuesta fue sí. Pero Marketing no necesitaba acceso al código interno ni a las APIs de desarrollo. Necesitaban sus propias herramientas.

OpenWebUI para Marketing

Configuramos OpenWebUI conectado al MCP Gateway con un perfil específico para el equipo de Marketing. Les dimos acceso a:

🔥 Firecrawl MCP

- Scraping inteligente de sitios web

- Análisis de contenido de competidores

- Extracción de tendencias del mercado

- Investigación de keywords y temas trending

📱 Meta Ads by PipeBoard

- Consulta de métricas de campañas en tiempo real

- Análisis de rendimiento de anuncios

- Sugerencias de optimización basadas en datos

- Reportes automáticos de ROI

📅 Mixpost MCP (Desarrollado Internamente)

- Programación de publicaciones en múltiples redes sociales

- Preview de posts antes de publicar

- Gestión de calendarios de contenido

- Análisis de mejores horarios de publicación

- El equipo de desarrollo lo creó específicamente para Marketing

🎨 MCPs de Generación de Imágenes

- DALL-E para creatividades

- Stable Diffusion para variaciones

- Midjourney para conceptos visuales

- Edición y optimización de imágenes

El Resultado

Antes:

- 🕐 6 horas/semana programando posts manualmente

- 📊 3 horas/semana generando reportes de Meta Ads

- 🔍 4 horas/semana investigando competencia

- 🎨 5 horas/semana esperando diseños del equipo creativo

Después:

- 🕐 30 minutos/semana (el AI programa todo desde lenguaje natural)

- 📊 15 minutos/semana (reportes automáticos con insights)

- 🔍 45 minutos/semana (Firecrawl hace el trabajo pesado)

- 🎨 1 hora/semana (generan variaciones ellos mismos)

Conversación Real en OpenWebUI:

Patricia: "Necesito programar 10 posts para la próxima semana sobre nuestro nuevo producto, con imágenes y copy optimizado para cada red social"

AI (vía MCP Gateway):Analiza tendencias con FirecrawlGenera 10 copies diferentes optimizadosCrea imágenes con DALL-E adaptadas a cada plataformaPrograma todo en Mixpost con horarios óptimosMuestra preview completo

Tiempo total: 8 minutos (antes: 3 horas)

Otros Equipos Potenciados

La arquitectura de federación nos permitió expandir rápidamente a otros equipos:

Equipo de Soporte

- Herramientas de análisis de tickets

- Acceso a base de conocimiento interna

- Búsqueda en documentación de productos

Equipo de Marketing

- Herramientas de scraping web (Firecrawl)

- Análisis de contenido y tendencias

- Generación de imágenes con IA

- Programación de publicaciones en redes sociales

Equipo de Ventas

- Análisis de leads y propuestas

- Generación de contenido comercial

- Acceso a información de productos

La Visión: Un Gateway, Múltiples Realidades

El MCP Gateway se convirtió en la capa de inteligencia universal de la empresa:

Cada equipo tiene su propio perfil de acceso, sus propios MCPs, pero todos comparten la misma infraestructura robusta, segura y observable.

Lecciones Aprendidas

1. La Autenticación es Crítica

Empezamos sin OAuth. Mal movimiento. En producción, implementamos:

- JWT para acceso programático

- OAuth con GitHub para SSO

- Equipos con permisos granulares

2. La Curación de Contenido Importa

No conectes todo. Sé selectivo:

- ✅ Documentación oficial actualizada

- ✅ Código interno bien mantenido

- ✅ APIs estables

- ❌ Repos experimentales

- ❌ Código legacy sin docs

- ❌ Proyectos abandonados

3. Observabilidad desde el Día 1

Implementamos logging detallado:

- Qué consulta cada desarrollador

- Qué recursos son más usados

- Qué equipos necesitan más contexto

Esto nos permitió optimizar continuamente.

4. El Cambio Cultural es Gradual

No todos adoptaron el AI inmediatamente. Algunos desarrolladores senior eran escépticos.

La estrategia: mostrar, no predicar. Los beta testers se convirtieron en evangelistas internos.

El Futuro

Estamos expandiendo el gateway:

Próximos Pasos:

- Integración con Jira (contexto de tickets)

- Conexión a Datadog (métricas y logs)

- MCP server custom para nuestra base de datos de clientes (queries seguras)

- Integración con Figma (para frontend)

Visión a 6 Meses:

Que cada desarrollador tenga un "copiloto" que conoce:

- Todo nuestro código

- Toda nuestra documentación

- Todos nuestros estándares

- Todo nuestro contexto de negocio

No un chatbot genérico, sino un asistente especializado en nuestra empresa.

🔒 Implementación Técnica Completa

La siguiente sección contiene la configuración exacta, arquitectura detallada y código de implementación que usamos para desplegar MCP Gateway en producción.

Leer la historia completa

Registrarse ahora para leer la historia completa y obtener acceso a todos los puestos para sólo suscriptores de pago.

Suscribirse