¿Estás listo para impulsar tu negocio en el mundo digital? En HiveAgile, sabemos lo crucial que es estar bien conectado en el entorno digital actual. Por eso, estamos emocionados de presentarte nuestros nuevos planes de membresía, pensados especialmente para adaptarse a lo que mejor te conviene, tanto en servicios como en presupuesto.

👉 Plan Mensual: Ideal para quienes buscan flexibilidad y compromiso a corto plazo. ¡Solo 12€ al mes! Haz clic aquí para más información

👉 Plan Trimestral Equilibrio perfecto entre compromiso y comodidad. 36€ cada tres meses. Descubre más aquí

👉 Plan Semestral: Únete a nosotros por seis meses a un precio especial de 73€. Infórmate más aquí

En HiveAgile, tu éxito es nuestra prioridad. Te ofrecemos la libertad de elegir cómo y cuándo invertir en tu crecimiento digital. ¡Es tu momento de destacar en el mundo digital con HiveAgile!

🌟 HiveAgile: Adaptándonos a ti, impulsando tu negocio.

Hola,

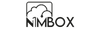

¡Esta semana ha estado llena de novedades! He estado a tope sacando cosas interesantes y, siendo sincero, un poco hiperactivo. Si recuerdas, la semana pasada te presenté:

Pues bien, además de añadir nuevos workflows, hemos logrado que estos se publiquen de forma automática y casi al instante en la comunidad de n8n.

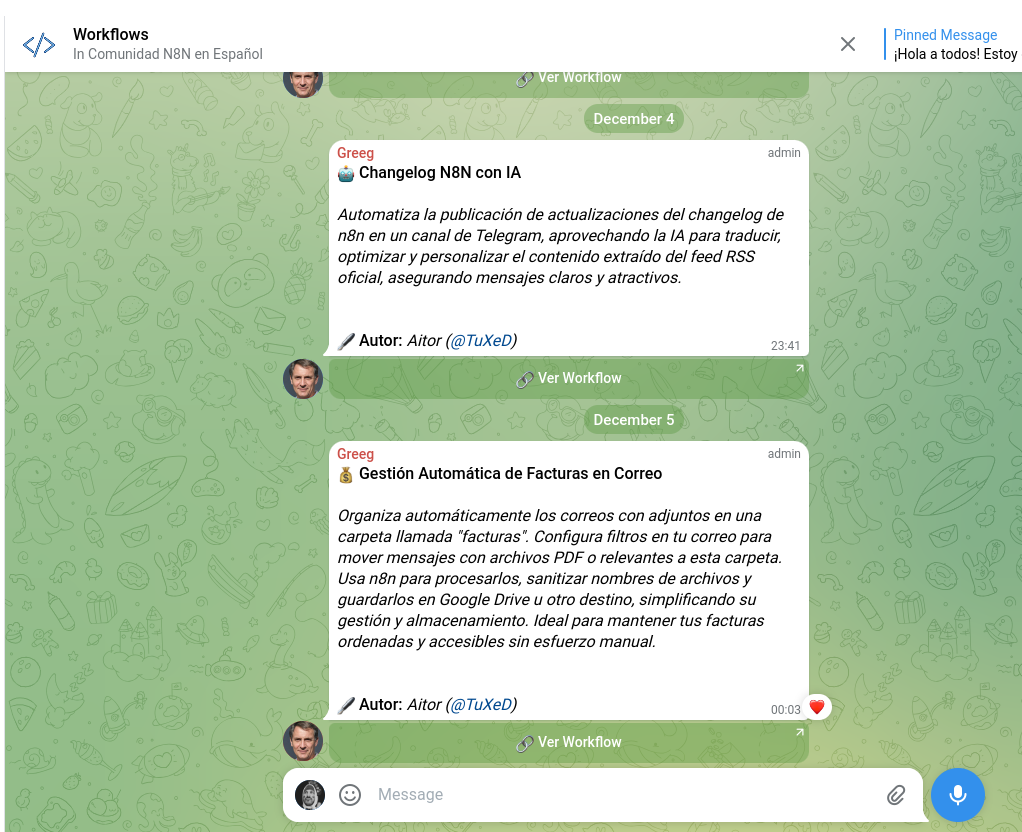

Además, en la comunidad ahora puedes crear tu perfil público ideal para mostrar tu portfolio como automatista 🤖. También hemos añadido una opción para que otros puedan contactarte directamente si deseas dar a conocer tus habilidades.

Estamos trabajando constantemente para mejorar la plataforma, ¡y cualquier persona puede colaborar! Te invitamos a participar y ser parte de las nuevas sorpresas que llegarán basadas en la colaboración comunitaria 🌟.

🎯 Aquí tienes un ejemplo de perfil: https://workflows.comunidad-n8n.com/user/8776348

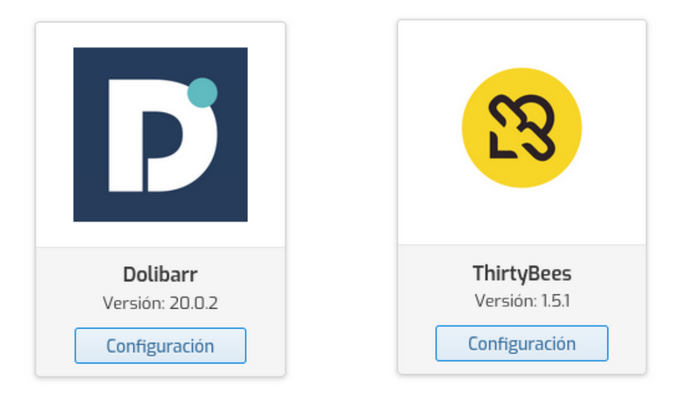

🚀 Novedades en HestiaCP: ¡Instala ThirtyBees y Dolibarr desde el instalador!

Estoy emocionado de compartir las últimas contribuciones que he realizado para mejorar la experiencia de los usuarios de HestiaCP. Ahora, tanto ThirtyBees como Dolibarr se podrán instalar directamente desde el instalador de HestiaCP, simplificando su despliegue en servidores. 🌟

🐝 ThirtyBees en HestiaCP

ThirtyBees, una plataforma de comercio electrónico rápida, segura y compatible con PrestaShop, ya está disponible para instalar desde HestiaCP. He enviado un Pull Request oficial, pero mientras tanto, puedes agregar esta funcionalidad a tu servidor con un simple comando:

wget https://github.com/aitorroma/notion/raw/refs/heads/main/thirtybees.tgz

tar xvfz thirtybees.tgz -C /

💬 Si quieres aprender más o compartir tus experiencias, únete a nuestro grupo de Telegram:

📢 @ThirtyBeesES

🅳 Dolibarr en HestiaCP

Para quienes necesitan un ERP/CRM modular y flexible, Dolibarr ahora también podrá instalarse desde el instalador de HestiaCP. He propuesto esta funcionalidad a través de un Pull Request oficial. Mientras se aprueba, puedes comenzar a usarlo copiando y pegando el siguiente comando en tu terminal:

wget https://github.com/aitorroma/notion/raw/refs/heads/main/dolibarr.tgz

tar xvfz dolibarr.tgz -C /

💡 Dolibarr es ideal para pequeñas y medianas empresas, con funcionalidades como contabilidad, gestión de proyectos, inventarios y mucho más.

Únete a la comunidad en Telegram:

📢 @dolibarr_spain

🌐 Únete a las comunidades:

- HestiaCP España: @hestiacpspain

- Mi canal: @aitorroma

Ambas integraciones están diseñadas para simplificar la vida de administradores de servidores y desarrolladores. Si eres parte de las comunidades ThirtyBees o Dolibarr, no dudes en probar estas nuevas opciones.

Sigamos construyendo juntos un ecosistema más eficiente y accesible.

¡Gracias por ser parte de esta aventura! 🙌

#HestiaCP #ThirtyBees #Dolibarr #OpenSource #Automatización

📌 LNKPost: La Herramienta Definitiva para Publicaciones en LinkedIn

¿Te cuesta optimizar tus publicaciones para LinkedIn? LNKPost está aquí para solucionarlo. Diseñada para crear y perfeccionar contenido profesional, esta aplicación no solo ahorra tiempo, sino que garantiza que cada post sea visualmente atractivo y tenga el impacto necesario para destacar en el feed de LinkedIn.

¿Qué hace LNKPost?

- 🚀 Optimización completa:

- Transforma tu texto en un post listo para LinkedIn.

- Añade negritas en Unicode, emojis llamativos y ajusta el formato automáticamente.

- 🎯 Contenido Potente con un GPT Especializado:

- Incluye un GPT integrado que analiza y mejora el contenido adaptándolo a tu audiencia.

- Sugiere mejoras, nuevas ideas o textos alternativos para maximizar el engagement y dar mayor visibilidad a tus publicaciones.

¿Por qué elegir LNKPost?

- 📈 Maximiza tu Impacto: Crea publicaciones que capten la atención de inmediato.

- ⏱️ Ahorra Tiempo: Todo en una sola herramienta, desde emojis hasta formato bold.

- 💡 Mejora Continua: Recibe sugerencias inteligentes para perfeccionar tu mensaje.

- 🧠 Personalización IA: El GPT integrado entiende tu tono y objetivos, ofreciendo textos adaptados a tu audiencia.

El Origen de LNKPost

He creado esta aplicación porque perdía demasiado tiempo en cada publicación de LinkedIn, si, es mía:

- Copiando emojis de una página.

- Pegando bold text de otra herramienta.

- Ajustando mis ideas dentro de los 1300 caracteres para hacerlas atractivas.

Además, quería que un GPT especializado me ayudara a optimizar el contenido desde el inicio, mejorando no solo el formato, sino también la relevancia y alcance de mis publicaciones.

Con LNKPost, tienes todo lo que necesitas para brillar en LinkedIn, desde la creación del texto hasta su optimización visual. Simplifica tu proceso y haz que cada publicación sea un éxito. 🚀🎯

Comparte esta newsletter

¿Te gusta nuestra newsletter sobre #NoCode y #OpenSource? Si quieres que sigamos ofreciendo contenidos accionables y de valor, ¡apóyanos! Una simple acción puede hacer una gran diferencia. Haz clic en el botón abajo y twittea para ayudarnos a crecer. 🚀

ℍ𝕠𝕣𝕚𝕫𝕠𝕟𝕥𝕖 𝔸𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝

Te presentamos "Horizonte Artificial", la nueva y flamante sección de nuestra newsletter dedicada exclusivamente a la Inteligencia Artificial. Pero no esperes el contenido convencional que inunda TikTok o YouTube. Aquí, nos sumergiremos en el fascinante mundo del OpenSource, explorando proyectos libres que puedes desplegar en tu propio servidor. Y para guiarnos en esta travesía, contamos con la experticia de Jesús Pacheco, mejor conocido en nuestra comunidad HiveAgile como "Chukowski". Prepárate para una perspectiva fresca y auténtica sobre la IA. ¡Bienvenidos al horizonte!

Los últimos días han estado cargados de novedades en inteligencia artificial, con avances que destacan tanto por su capacidad técnica como por su impacto potencial. Aquí tienes un resumen de lo más relevante y cómo podrías beneficiarte.

OpenAI y GPT-4 Turbo

OpenAI lanzó la versión completa de GPT-4 Turbo ("0.1"), junto con un nuevo plan de suscripción "Pro" de $200 al mes. Las mejoras incluyen acceso ilimitado al modo de voz avanzado y una ventana de contexto ampliada a 128,000 tokens, cuatro veces más grande que antes.

¿Es necesario el plan Pro? Para la mayoría de los usuarios, probablemente no. Si no alcanzaste los límites de tu plan actual al menos tres veces en el último mes, el Pro no será esencial. Sin embargo, para desarrolladores y usuarios intensivos que necesitan consistencia y mayor capacidad, esta actualización puede ser valiosa.

Anthropic y el Protocolo MCP

Anthropic presentó el protocolo MCP para Claude, permitiendo la conexión con herramientas externas como navegadores web y APIs. Esto amplía las capacidades del modelo, abriendo un mundo de posibilidades para usuarios avanzados que busquen mayor integración y automatización.

Generación de Video y Modelos 3D

Un modelo de generación de video de código abierto está impresionando con su calidad, rivalizando con opciones comerciales más caras, aunque con un costo de 50 centavos por clip. Además, tanto World Labs como Google DeepMind presentaron modelos que crean mundos 3D navegables a partir de texto o imágenes. Aunque aún en fases iniciales, estos mundos muestran consistencia temporal, lo que sugiere aplicaciones prometedoras para videojuegos y simulaciones.

Klingg y el Probador Virtual

Klingg introdujo una herramienta de prueba virtual de ropa basada en avatares de IA. Aunque todavía tiene desafíos (como ajustes imperfectos), es un primer paso hacia probadores virtuales que podrían revolucionar el comercio electrónico de moda.

11 Labs y la Competencia en Voz

11 Labs entró al mercado de agentes de voz IA, directamente enfrentándose al modo de voz avanzado de OpenAI. Su plataforma destaca por una integración sencilla, respuestas fluidas y opciones de personalización con soporte para webhooks.

La Nueva Familia de Modelos de IA de Amazon

Amazon ha dado un paso firme en el competitivo terreno de los modelos fundacionales con el lanzamiento de su nueva familia de modelos de inteligencia artificial, denominada Nova. Más allá de su entrada en la contienda al más alto nivel, lo que realmente destaca es la estrategia que Amazon ha adoptado para diferenciarse.

Tres Claves de los Modelos Nova

- Multimodalidad Avanzada

Los modelos Nova pueden procesar texto, imágenes y videos como entradas y generar resultados en cualquiera de estos formatos. Aunque la multimodalidad no es nueva, la implementación de Amazon destaca por su eficiencia y simplicidad. - Rentabilidad Extraordinaria

Nova Light, el modelo más accesible de la familia, es considerablemente más económico que sus competidores. Para ponerlo en perspectiva, mientras modelos como Claude de Anthropic cobran 80 centavos por millón de tokens, Nova Light lo hace por solo 6 centavos, un ahorro de más de 12 veces. - Optimización para Agentes

A diferencia de muchos modelos que se enfocan en la conversación general, Nova está diseñado para interactuar de manera eficiente con APIs y herramientas externas. En benchmarks de funcionalidad, como las pruebas de llamadas a funciones de Berkeley, Nova supera significativamente a modelos más costosos.

Un Cambio de Paradigma en la IA

Esta estrategia de Amazon refleja un giro en la manera en que concebimos la utilidad de los modelos de inteligencia artificial. Durante mucho tiempo, la conversación y la capacidad de razonamiento han sido el foco principal, pero el futuro parece dirigirse hacia modelos que no solo conversan, sino que actúan como agentes autónomos.

Imagina un asistente de viajes que no solo responde preguntas, sino que puede buscar vuelos, consultar el clima, verificar tu calendario y realizar reservaciones. O un asistente de programación que no solo sugiere fragmentos de código, sino que interactúa directamente con GitHub y ejecuta pruebas automatizadas. Amazon ha optimizado los modelos Nova específicamente para este tipo de tareas.

Con un contexto extenso de hasta 300,000 tokens, los modelos Nova destacan en seguir instrucciones complejas y estructuradas. Aunque no buscan sobresalir en conversaciones informales, su enfoque en tareas prácticas e integraciones empresariales podría convertirlos en herramientas indispensables.

Una Jugada Estratégica

Amazon no está intentando derrotar a ChatGPT en el juego de la conversación general. En cambio, está apostando por un nicho con alto potencial de impacto: la automatización empresarial. Esta estrategia recuerda el enfoque inicial de Jeff Bezos con la venta de libros, un producto ideal para el comercio electrónico por su facilidad de almacenamiento y envío. Hoy, Amazon parece estar aplicando una lógica similar en el ámbito de la IA, diseñando modelos optimizados para tareas prácticas, económicos y altamente eficientes.

Si su estrategia es correcta, podríamos estar frente al inicio de una nueva era en la inteligencia artificial, en la que el protagonismo se desplazará de la conversación a la acción. Y, al igual que con los libros, Amazon podría haber encontrado su puerta de entrada perfecta para liderar este cambio.

Llama 3.3: La Revolución de la Eficiencia en Modelos de Lenguaje

Meta ha dado un golpe sobre la mesa con el anuncio de Llama 3.3, un modelo de lenguaje que redefine lo que significa eficiencia. Es como construir un motor de alto rendimiento que funciona con la energía de un pequeño generador.

¿Qué hace especial a Llama 3.3?

Lo más sorprendente de este modelo es que ofrece el rendimiento de un gigante de 405 mil millones de parámetros, pero empleando solo 70 mil millones. Imagínalo como comprimir el conocimiento de toda una biblioteca en el espacio de una mochila.

¿Por qué importa?

- Costo Ultracompetitivo

Llama 3.3 es increíblemente económico. Mientras que modelos como GPT-4 cobran alrededor de $250 por millón de tokens, Llama 3.3 solo cuesta 10 centavos. Es la diferencia entre un viaje en taxi y recorrer la misma distancia en bicicleta: el destino es el mismo, pero el precio no podría ser más diferente. - Accesibilidad Local

Aunque requiere hardware robusto para ejecutarse, no depende de la nube. Puedes descargarlo y ejecutarlo en tu propio sistema, como tener una minicentral eléctrica en casa. Esto abre posibilidades para usuarios con necesidades específicas y preocupaciones de privacidad.

Resultados que impresionan

Evaluaciones independientes de Artificial Analysis muestran un salto en calidad de 68 a 74 puntos en su índice, un nivel que lo pone a la par de modelos significativamente más grandes. Este avance lo convierte en una opción competitiva no solo en términos de costo, sino también de rendimiento.

En mis pruebas, Llama 3.3 demostró ser versátil. Aunque no supera a modelos especializados como Claude en la generación de código, su capacidad para seguir instrucciones y crear contenido coherente es sobresaliente. Es como un estudiante que destaca en múltiples áreas, aunque no siempre sea el mejor en una sola disciplina.

¿Cómo logró Meta esta hazaña?

La clave está en su proceso de alineación y en técnicas avanzadas de aprendizaje por refuerzo online. Es como encontrar una nueva fórmula de entrenamiento para atletas que mejora el rendimiento con menos recursos. Además, el modelo maneja un contexto de 128,000 tokens y ha sido entrenado con 15 billones de tokens, integrando datos hasta diciembre de 2023. Piensa en ello como la diferencia entre un ávido lector de miles de libros frente a uno que solo ha leído unos cuantos.

Opciones de implementación

Proveedores como Deep Infra, Hyperbolic, Gro, Fireworks y Together AI ya ofrecen acceso al modelo, cada uno con distintas ventajas en velocidad y precio, como elegir entre aerolíneas que te llevan al mismo destino pero con diferentes comodidades.

Un salto en la evolución de la IA

Llama 3.3 representa un cambio de paradigma. No solo por lo que puede hacer, sino por cómo lo logra: más eficiente, más accesible y más práctico. Es un recordatorio de que, en tecnología, el progreso no siempre está en hacer algo más grande, sino en hacerlo más inteligente.

Reflexión: La IA como Transformador de Industrias

Lo más impactante de estos avances no es solo su sofisticación técnica, sino cómo están transformando industrias enteras. Desde herramientas de productividad hasta entretenimiento y comercio, cada semana nos acerca más a un futuro donde la IA no es solo una herramienta, sino una parte integral de cómo trabajamos, creamos y vivimos.

- 🐥 Únete a nuestra vibrante comunidad en Twitter y mantente en la vanguardia: descubre herramientas innovadoras, participa en nuestro emocionante #BuildInPublic y mucho más.

- 💌 ¿Tienes algo que compartir? No dudes en contactarnos. Tu voz es importante para nosotros y nos comprometemos a responder a la mayor brevedad posible.¡házmelo saber!

En el mundo de la inteligencia artificial, la recuperación de información siempre ha sido un desafío crítico. Los sistemas tradicionales de generación aumentada por recuperación (RAG, por sus siglas en inglés) han cumplido bien su propósito en tareas simples, pero fallan cuando se enfrentan a consultas complejas que requieren información de múltiples fuentes o una estructura lógica avanzada. Aquí es donde entra el RAG Agéntico, una evolución que combina lo mejor de los modelos de lenguaje con agentes especializados para descomponer y estructurar consultas.

En este artículo, exploraremos las diferencias entre el RAG tradicional y el RAG agéntico, cómo implementarlos y los beneficios clave que puedes obtener al adoptar esta tecnología de vanguardia.

Diferencias Clave entre RAG Tradicional y RAG Agéntico

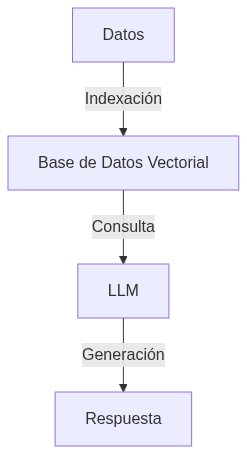

RAG Tradicional

El enfoque tradicional de RAG se basa en indexar datos en una base de datos vectorial (Vector DB) y realizar consultas sobre estos datos. Cuando se plantea una pregunta, el sistema busca en los datos, genera una respuesta y devuelve el resultado.

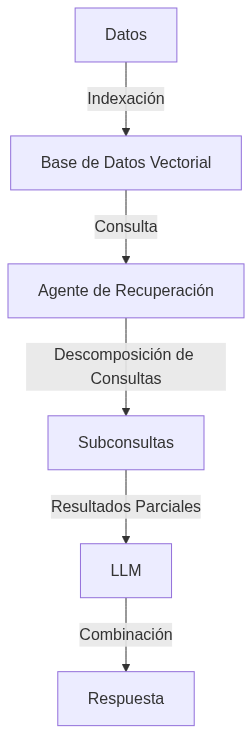

RAG Agéntico

El RAG agéntico añade una capa de inteligencia: un agente especializado que puede:

- Dividir preguntas complejas en partes más simples.

- Realizar múltiples búsquedas simultáneamente.

- Validar la relevancia de la información encontrada.

- Combinar las respuestas en una única solución coherente.

Beneficios del RAG Agéntico

- Mayor Precisión

Los agentes pueden validar y combinar información de múltiples fuentes, asegurando que las respuestas sean coherentes y relevantes. - Soporte para Consultas Complejas

La capacidad de dividir consultas en partes más simples permite responder a preguntas que antes eran imposibles de manejar. - Flexibilidad

Se puede integrar con múltiples bases de datos, modelos y herramientas. - Validación Automática

Reduce errores al validar automáticamente la información obtenida.

Limitaciones del RAG Agéntico

- Latencia Mayor

Dividir consultas y combinar resultados puede llevar más tiempo. - Uso Intensivo de Recursos

Los modelos de lenguaje grandes requieren un hardware adecuado para un rendimiento óptimo. - Complejidad en la Configuración

La implementación y el mantenimiento requieren experiencia técnica.

Implementación del RAG Agéntico

A continuación, te explicamos cómo implementar un sistema RAG agéntico utilizando tecnologías modernas como pgvector y modelos de lenguaje como GPT-4.

Requisitos

- Framework como phi.data.

- Una base de datos vectorial como

pgvector. - Modelos de lenguaje avanzados como

OpenAI GPT.

Leer la historia completa

Registrarse ahora para leer la historia completa y obtener acceso a todos los puestos para sólo suscriptores de pago.

Suscribirse